データの統合と移行は、非常に圧倒され、複雑になりがちであり、さまざまなソースと移行先の間でのデータを管理の複雑さは、すぐ過小評価されてしまいますが、綿密な計画と適切な ETL(抽出、変換、格納)のセットアップなしにこの作業に飛び込むと、ビジネス目標や納期に影響を与えたり、予算オーバーになったりする可能性があります。データ量が増加し続ける中、適切なツールと戦略でデータ管理に取り組むことが極めて重要なのです。

そこで本記事では、Microsoft SQL Server の主要な ETL ツールについて掘り下げてデータ統合と移行プロセスを最適化するためのヒントをご紹介し、エラーを減らす方法についてお話します。

- 移行用データの準備(データクリーニング、検証、マッピング、変換)

- 増分負荷、全負荷、並列処理

- 一括読み込み、データ分割、インデックス戦略

- 変換、スケジューリング、モニタリング、その他の方法によるデータ統合の強化

目次

- はじめに

- データ移行におけるETLの理解

- データ移行のアプローチ 従来型とETLベースの比較

- ETLツールのメリット

- Microsoft SQL ETLツール7選

- データ移行を最適化するベストプラクティス

はじめに

ETL ツールを使うことで、データ移行と統合プロセスが大幅に改善されます。このプロセスには、多様なソースからのデータ抽出や、目的の移行先への格納など、複数のステップが含まれ、そのステップと変換の自動化は、適切かつ予定された統合のために非常に重要です。そこで重要な役割を果たすのが ETL(抽出、変換、格納)ツールです。ETL ツールは、これらのプロセスを自動化し、データ統合ワークフロー全体を効率化するのに必要な機能を提供します。

本記事でこれから見ていきますが、Microsoft SQL ETLツールは、Integrate.io、Talend、Azure Data Factory、Informatica、Microsoft 独自の SSIS(SQL Server Integration Services)など、多くが利用可能です。

Microsoft ETL ツールは、さまざまなソースからのデータ統合が必要な企業にとって効率的なソリューションです。適切に実行されたプロセスはエラーを減らし、それによって信頼性の高いインサイトと効率の向上がもたらされます。

ETLツールを活用する主な利点は以下が挙げられます:

- スケーラビリティ(拡張性):ETL ツールで、自動スケーリングや並列処理などの機能により、大量データの処理が可能になり、このような機能により、企業は時間とともに変化するワークロードの需要に対応することができる。

- データアクセシビリティ:ETL ツールはデータを抽出し、一貫性のある形式に変換し、データウェアハウスやデータレイクに保存する。それによって、データがどこに保存されているかに関係なく、必要なときにいつでも利用でき、アクセスできることが保証される。

- コスト削減:ETL ツールで、手作業でやらないといけないことが減ることにより、手作業によるコスト関連のトラブルやミスの可能性を減らすことができる。

- セキュリティおよびガバナンス:ETL ツールには、データのセキュリティとガバナンスを保証する機能があり、それによって適切な管理が実施され、業界ルールに準拠し、データの整合性、機密性、プライバシーが確保される。

データ移行における ETL の理解

ETLツールは、データ移行および統合プロセスを効率化する上で重要な役割を果たします。ここでは、ETLツールがどのようにこれを実現するのかを簡単にみていきましょう:

- データ抽出:このフェーズでは、データベース、ファイル、API などのさまざまなソースからデータを取得し、データの形式は、CSV、JSON、XMLなどさまざまである。ETL ツールには、様々なソースと接続して色々なフォーマットのファイルを処理することができる、あらかじめ構築されたコネクタがある。

- データ変換:ソースから取り出されたデータは、必ずしもすぐに使えるフォーマットで提供されるとは限らない。そこで、データが抽出されると ETL ツールがデータ変換を支援し、それによって希望するデータ形式や要件が満たされる。変換フェーズでは、抽出されたデータは一貫性のある意味のある形式に変換され、このステップでは、データはビジネスニーズに合わせるべく、クリーニング、フィルタリング、検証される。

- データの格納: この最終フェーズでは、変換されたデータをデータベース、データウェアハウス、データレイクなどの目的地に格納し、ETL ツールは、バッチ処理や並列ロードなどの機能により、格納のプロセスをしやすくする。データを効率的に格納することで、レポーティング、可視化、意思決定プロセスで利用できるようになる。

- ワークフロー管理: ビジネスやデータ要件に応じて、ETL プロセスは管理されてタイムリーに実行できるようにスケジューリングされる必要がある。ETL ツールは、データ統合および移行のワークフローを設計してスケジュールできる視覚的なインターフェースを備えた機能を提供する。

- エラー処理とモニタリング: ETL ツールで、パイプラインの実行をモニタリング(監視)し、発生したエラーを記録することができる。アラート、トリガー、失敗したタスクの再試行などの機能により、企業は変換の失敗をデバッグし、エラーの可能性を最小限に抑えることができる。

データ移行のアプローチ: 従来型と ETL ベースの比較

従来のデータ移行プロセスと ETL ベースのデータ移行アプローチには大きな違いがあり、後者の方が著しく効率的です。では、その違いについて詳しく見ていきましょう:

-

複雑さ

- 従来のアプローチでは、あるソースシステムからターゲットシステムへデータを移動するために、カスタムスクリプトを手作業で作成しており、このアプローチは、特に、カスタムスクリプトが特定のソースシステム用に調整されている場合などは複雑で時間がかかる。

- ETL ベースのアプローチは、ソースシステムへの接続プロセスをしやすくする内蔵コネクタを提供することで、移行タスクをシンプルにする。視覚的なインターフェースにより、抽出、変換、格納のプロセスを効率的かつ迅速に行うことができる。

-

スケーラビリティ

- 従来のアプローチでは、大量のデータを扱うときに大変であり、特にビッグデータを扱う場合、手作業によるプロセスはパフォーマンスの問題を引き起こす可能性がある。

- ETL ベースのアプローチだと、データ量が増えてもスムーズな移行が保証される。ETL ツールは、並列処理やスケーラブルなリソースなどの機能により、大量のデータを処理できるように構築されている。

-

データの整合性

- 従来のアプローチにはデータ検証機能がないため、デスティネーションでのデータの不一致につながる可能性がある。

- ETL アプローチは、「データ検証」と「エラー処理機能」を提供することで、その課題を克服し、エラーログとデータ品質チェックで、正確なデータ移行が保証される。

-

自動化

- 従来のアプローチでは、移行プロセス全体を通して手作業で関わる必要が大いにあることから、自動化が難しく、人為的なミスが発生する可能性が上がる。

- ETL アプローチで、自動化とモニタリングのプロセスがしやすくなる。ETL ツールに自動化のための機能があることから、手作業ですることが少なくなる。

ETL ツールのメリット

データ移行や統合作業に ETL ツールを活用することで、企業はデータフローを最適化し、効率を上げることができます。そこで、主なメリットをいくつか挙げてみましょう:

- 効率性: ETL ツールを使うことで、データの抽出、変換、格納のタスクが簡単に自動化され、移行プロセスの効率化につながる。

- データの整合性: ETL ワークフローには、データのクリーニング、検証、変換といったいくつかのステップがあり、そのステップで、データ移行プロセスを通じてデータの正確性と一貫性が保証される。ツールで矛盾や不一致を特定でき、それがデータ品質と整合性の向上につながる。

- シームレスな統合: ETL ツールには、ソースデータとターゲットデータベースをリンクさせる数百ものコネクタが内蔵されている。それによって、企業は異種ソースからのデータを統合し、さまざまなデータ形式を扱うことができる。

- 柔軟性と拡張性: ETL のワークフローは、特定のビジネス/データ要件に合わせてカスタマイズすることができ、同時に大量のデータを処理することもできる。企業は、データ変換によって多様なデータ構造とフォーマットを統合することができる。

- 費用対効果: ETL ツールで、手作業で行わないといけないことやエラーが減るため、コスト関連のエラーが発生する可能性が下がる。

- カスタマーサポート: 従来のアプローチに従う場合、問題発生の際にデバッグと問題解決は面倒なプロセスになる可能性がある。ETL ツールでは、トレーニングを受けたスペシャリストに問い合わせができることから、迅速な解決が可能

Microsoft SQL の ETL ツール 7選

Microsoft の ETL ツールは、さまざまなソースからデータを抽出し、ビジネス標準に合うように変換し、目的のデータベースに格納するために開発されたソフトウェアアプリケーションです。よく使われている ETL ツールはたくさんありますが、代表的なものを詳しく見てみましょう:

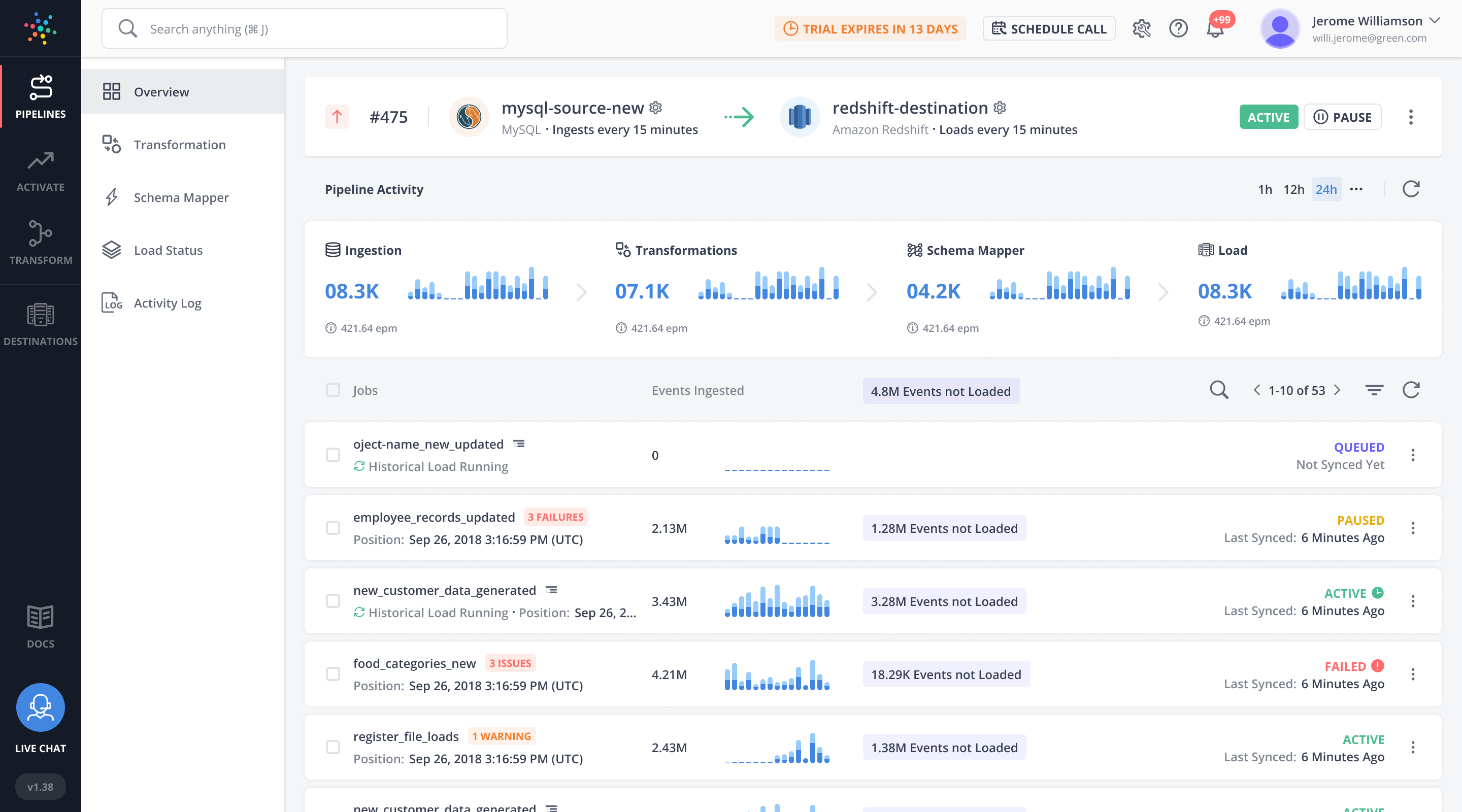

1.Integrate.io

G2 の評価:5つ星中4.3

Integrate.io はクラウドベースのデータ統合プラットフォームであり、これで企業は、複数のソースから Microsoft SQL データベースへのデータの抽出、変換、格納ができるようになります。このプラットフォームは、企業が Microsoft SQL のサーバーにデータを送信してそれを他のデスティネーションのシステムにプッシュバックするのに役立つ高度な ETL およびリバース ETL 機能を提供します。また、Integrate.io は、Snowflake、Salesforce、Netsuite、Amazon Redshift、Shopify などの豊富な内蔵コネクタセットを備えており、企業は複数のソースからデータを抽出することができます。

さらに Integrate.io は、直感的でユーザーに優しいドラッグ&ドロップ式のインターフェースにより、ワークフローを設定し、パイプラインを迅速にデプロイすることができます。他のツールとは違って、Integrate.io を使う場合、企業は大規模な技術トレーニングを受ける必要はありません。

主な機能

- ETL およびリバース ETL

- ELT(抽出、格納、変換) と CDC(変更データキャプチャ)

- API 管理

- データオブザーバビリティ

- 100以上の内蔵コネクタ

- 220以上のデータ変換

- ローコード/ノーコード操作

料金

このプラットフォームは、使用するコネクタごとにわかりやすく柔軟な料金が設定されておおり、プラットフォームはデータ量に関係なく、コネクタごとに定額料金を請求するだけになっています。

Integrate.io は、使用量に応じた3つの料金プランを以下のように提供しています:

- スタータープラン(年額 $15,000):無制限のパッケージ、転送、ユーザー、コネクタx2、スケジューリングクラスタ

- プロフェッショナルプラン(年額$25,000): 99.5%のSLA(サービス品質保証)、高度なセキュリティ機能、スケジューリングクラスタx2

- エンタープライズプラン(ニーズに合わせてカスタマイズ): 高度なデータ統合を必要とする企業に最適。無制限の REST API コネクタ、ソース管理開発、QA アカウント、SOC2 監査レポートなどあり。

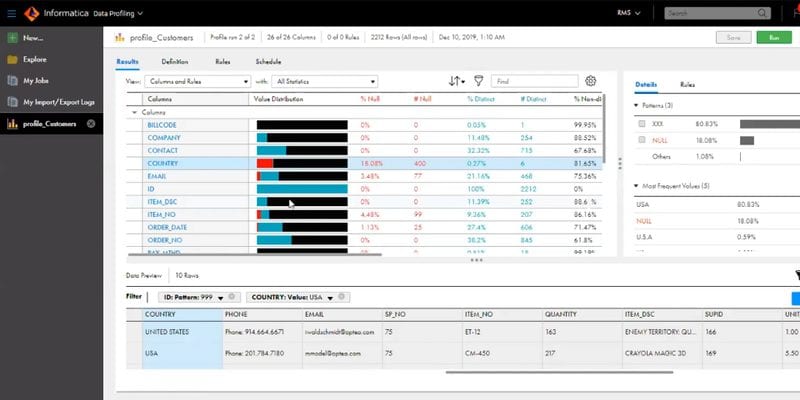

2.Informatica

G2 の評価:5つ星中4.4

Informatica は、汎用性の高いデータ統合および管理システムであり、多様なソースから効率的にデータを抽出し、特定のビジネスニーズに基づいて必要な変換を適用し、処理したデータを SQL Server データベースに格納します。また、さまざまなオンプレミスのデータソースやクラウドサービスに対応する幅広いコネクタを備えています。

主な機能

- ETL/ELT

- CDC

- 数百のコネクタ

- オンプレミスおよびクラウドベースのツールとの統合

料金

Informatica の基本プランは、月額 $2,000 からあります。

3.Azure Data Factory

G2 の評価:5つ星中4.5

Azure Data Factory(ADF ) は、複雑でカスタマイズ可能なタスクを実行できるMicrosoft のフルマネージド・クラウドベースのデータ統合プラットフォームであり、ETL と ELT の機能とともに、Git と CI/CD のサポートも内蔵されています。また、コネクタで、オンプレミスの SSIS(SQL Server Integration Services)とクラウド環境間のシームレスなデータ移行が可能になります。

主な機能

- ノーコードの ETL および ELT

- 90以上の内蔵コネクタ

- GUI およびスクリプトベースのインターフェース

- ETL の自動化とモニタリング機能

料金

Microsoft の Azure Data Factory では、30日間 $200 のクレジットが提供され、その後の利用は従量課金モデルとなります。

4.Talend

G2 の評価:5つ星中4.0

Talend は革新的なデータ統合ソリューションです。多様なコネクタがを提供されているので、さまざまなソースからのデータ統合ができます。直感的な UI(ユーザーインターフェース)により、企業は ETL パイプラインをサッと構築およびデプロイできます。また、Talend はパイプライン用の Java コードを自動的に作成するため、コードを書く必要がありません。

主な機能

- ETL/ELT

- CDC

- 強固な実行

- メタデータ主導のデザインと実行

- 多様な内蔵コネクタセット

料金

Talend は14日間の無料トライアルを提供していますが、料金の詳細は明らかにしていません。

5.Hevo Data

G2 の評価:5つ星中4.3

Hevo では150以上のコネクタが提供されているので、複数のソースからのデータ統合ができ、それによって、企業はほぼリアルタイムでデータを統合できるようになります。その他の特筆すべき機能としては、リアルタイムデータ統合、スキーマ自動検出、ビッグデータ処理機能などがあります。

主な機能

- ELT

- CDC

- 150以上のデータソース

料金

無料利用枠では、ユーザーは最大 100 万件のレコードを取り込むことができ、その後は月額 $239 ドルで追加機能を利用できます。

6.SSIS(SQL Server Integration Services)

G2 の評価:5つ星中4.6

SSIS(SQL Server Integration Services)は、ETL 機能のための強力なマイクロソフトツールであり、ユーザーがさまざまなソースから効率的にデータを抽出、変換、格納することができる簡単なデータ変換方法を提供します。

SSIS は Microsoft SQL Server のコンポーネントですが、習得が難しかったり、複雑であったり、サードパーティのコネクターオプションが限られていたりと、いくつかの制限があるため、それで企業は SSIS の代替品を探すようになってしまいがちです。

主な機能

- Microsoft SQL Server の一部

- SSIS パッケージは Visual Studio 経由でデプロイ可能

- 内蔵データ変換機能

料金

SSIS は SQL Server ライセンスに統合されており、ライセンス費用は 230ドル からあります。

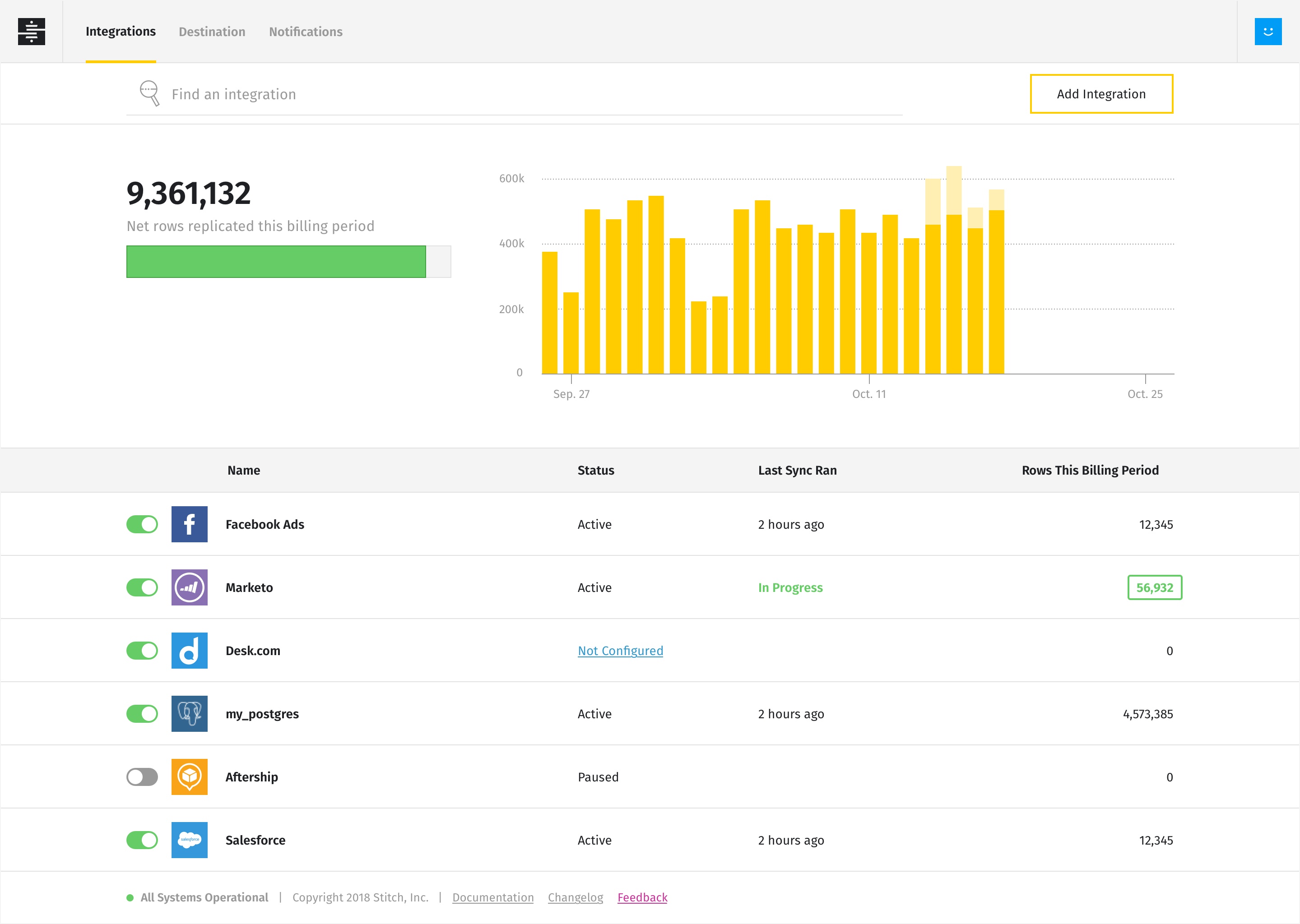

7.Stitch

G2 の評価:5つ星中4.5

Stitch はコード不要のクラウドベースの ETL ツールで、ユーザーは ETL 機能の実行ができます。約130以上のデータソースコネクタが提供され、それで企業は様々なソースからデータを抽出できます。また、スケジューリングやデータ複製などの機能により、カスタムコードを書く必要がありません。

主な機能

- ETL

- 130以上の内蔵コネクタ

- ノーコードツール

料金

Stitch には3つの料金プランがあり、スタンダードなものは月額 $100から(行数によって異なる)で、プレミアムなものは月額 $2500 となっています。

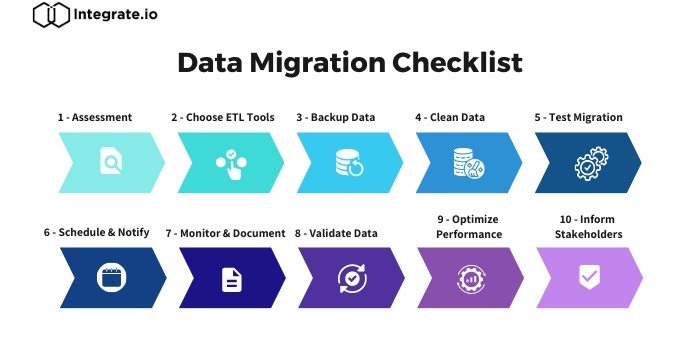

データ移行を最適化するベストプラクティス

移行用データの準備

データのクレンジングと検証

データ抽出は、ETL プロセスの不可欠なフェーズであり、データのクレンジングと検証は、データの完全性と一貫性の確保に欠かせません。

データクリーニングには、ソースデータの矛盾や不正確さを特定し、それを修正することが含まれ、重複レコードの削除、Null(ヌル)値の修正、フォーマットの標準化などもできます。それによって、データの信頼性が確保されます。

また、データ検証にはデータ品質の検証も含まれます。これは、データ品質をテストするために特定のルールと制約を事前に確定することによって行うことができ、このステップで、データの不一致の特定や、データの完全性の確保ができます。

データマッピングと変換

シームレスな統合を実現するためには、「ソースデータ」と「デスティネーション構造」の関係が早期に確立されないといけません。そしてソースデータとデスティネーション構造を整合させるには、データを対応するフィールドや属性にマッピングまたは変換する必要があります。

ETL ツールは、ソースデータに適用できる様々な変換を提供します。これには、フィルタリング、集計、結合、分割などの複数の操作が含まれ、このステップにより、企業はデータがビジネスニーズに合致していることを確認できます。

効率的なデータ抽出技術

増分負荷と全負荷の比較

増分負荷の処理では、最新の変更のみがソースデータから抽出され、デスティネーションに統合されます。このアプローチは増分の変更のみを考慮するため、特にビッグデータを扱う場合に効率的で高速です。

一方、フルロード方式では、最近の変更に関係なく、毎回ソースデータの完全な統合を考慮します。この方法でデータの完全性は保証されますが、時間がかかり、リソースは大量に消費されます。

並列処理

並列処理とは、データをソースからデスティネーションに統合するためのデータパイプラインにおいて、複数のタスクを同時に実行することを指します。このプロセスは、データとタスクをより小さな単位に分割し、さまざまなスレッドまたはプロセッサで処理することで、データ統合プロセスを大幅に高速化します。

データロード時のパフォーマンス最適化

バルクロード

バルクロード方式では、データを一括して格納するため、統合プロセスが大幅に改善されます。また、大量のデータが含まれる場合、一連の行またはデータのバッチを格納することで、データ格納のパフォーマンスが上がります。

インデックス(索引)戦略

データをインデックス化することで、データベースはレコードをサッと検索して取り出すことができ、それによって、クエリの実行速度が上がります。また、これは ETL プロセスの最適化において重要な役割を果たします。以下にインデックス作成方法をいくつか挙げてみましょう:

- プライマリ・キー・インデックス:プライマリ・キーは、データの迅速なクエリに役立つテーブルの各行に対して一意な行識別子である。

- 外部キーインデックス: 外部キーは、あるテーブルのプライマリーキーを別のテーブルの外部キーにリンクすることで、構造間のリンクを確立し、これで効率的なデータ結合やマッピングが実現する。

- カラム・インデックス: このプロセスには、データ構造内の特定のカラムにインデックスを付けることが含まれ、これによって、頻繁に照会されるカラムのデータ検索がより速くなる。

- クラスタ化インデックス: クラスタ化インデックスは、テーブル内の行の物理的な順序を決定することで機能する。順序付けられたデータは、ETL プロセスでサッと取り出すことができる。

データの分割

データの分割では、データセットをデータ範囲、リスト、ハッシュなどの特定の基準に基づいてより小さなパーティショニングに分割します。一連の基準に基づいて作業負荷を分散することで、データベースのエンジンは、テーブルを完全にスキャンするのに比べて、効率的にデータをクエリすることができます。

データの完全性の確保とエラー処理

データ品質チェック

データ品質チェックは、データ統合および移行プロセスに不可欠です。これらのチェックにより、データの完全性、一貫性、信頼性が確保され、データに欠陥やエラーがある場合、これらのチェックで問題を早期に特定することができます。

その主な側面を以下にいくつか挙げてみましょう:

- データプロファイリング:ソース・データの構造、品質、パターンを調査し、異常や矛盾がないかをチェックする

- データクレンジング:重複の削除、Null(ヌル) 値の充填または削除、データフォーマットの標準化など

- データ検証:ソース・データをテストするために、あらかじめ決められたルールと制約のセットを持つ。

- データの一貫性と正確性:関連するソース構造間のデータの一貫性をチェックし、ビジネス要件を反映していることを確認するためにデータの正確性を検証する

モニタリングとエラーログ

データの移行および統合プロセスにおける ETL データパイプラインのモニタリングは、スムーズな実行とデータフローを確保する上で重要な役割を果たします。Integrate.io、Azure Data Factory などの ETL ツールには、パイプライン実行中にカスタム通知を設定できる機能が組み込まれており、これで潜在的な問題をモニタリングすることができます。

エラーログとアラートで、いつ特定の ETL のデータパイプラインコンポーネントに障害が発生したかわかります。また、エラーログで、エラーのデバッグと解決ができます。ETL ツールはエラー処理メカニズムを提供しており、失敗したコンポーネントを再試行することができるのです。

まとめ

上記を読み飛ばした方のために、SQL Server の ETL ツールを使用するメリットと、データ統合および移行プロセスを最適化するためのベストプラクティスを簡単にご紹介します:

SQL Server の ETLツールを使用する主なメリット:

- 効率化されたデータ統合

- 効率性の向上

- データ品質、整合性、ガバナンス、セキュリティ

- 拡張性と柔軟性

- 包括的なモニタリングとエラー処理

ETL のベストプラクティス

- データのクレンジングと検証を行い、完全性と一貫性を確保する。

- マッピングまたは変換によって、ソース・データとデスティネーション構造の関係を確立する。

- 最近の変更をより速く処理するために、増分負荷を考慮する。

- 完全なデータ統合のための全負荷のトレードオフを評価する。

- バルクロードを使って、大量データの統合パフォーマンスを上げる。

- インデックス戦略(主キー、外部キー、カラム、クラスタ化など)を実装し、データ検索を高速化する。

- 効率的なクエリのために、データセットを特定の基準に基づいてより小さく分割する。

- データ品質チェック(プロファイリング、クレンジング、検証など)を実施し、信頼できるデータを確保する。

- 迅速なデバッグと解決のためにエラーをモニタリング(監視)し、ログに記録する。

- 実行中の ETL パイプラインを監視するためのカスタム通知を設定する。

- エラーログとアラートを活用して、パイプラインの障害を特定および対処する。

ここまでで、皆さんはビジネス ニーズに適した ETL ツールを選択し、データを統合または移行して ETL プロセスを最適化するためのベスト プラクティスを理解できる立場にあります。

迅速なセットアップと簡単な操作の ETL ツールをお探しなら、Integrate.io のご利用をぜひご検討ください。ドラッグ&ドロップのコンポーネント、データ変換方法、迅速なカスタマーサポート、シンプルな価格モデルで、あらゆるデータニーズに対応できます。

Integrate.io で効率化されたデータの統合および移行をご体験になりませんか。

こちらから14日間のトライアルにサインアップするか、こちらからデモを予約して、Integrate.io のメリットをぜひ直接お試しください!